|

Finalmente! John Clauser, Alain Aspect e Anton Zellinger hanno ricevuto il premio Nobel per la fisica. Finalmente perché sono passati esattamente cinquant’anni dal primo dei loro esperimenti che hanno motivato l’ambìto riconoscimento accademico, finalmente perché si premiano lavori sui fondamenti della meccanica quantistica, la scienza che più di ogni altra ci svela la natura della realtà. Una natura che appare “bizzarra”, almeno secondo il nostro metro di giudizio e la nostra logica occidentale di aristotelica fondazione, e che ci costringe a rivoluzionare completamente il nostro modo di pensare.

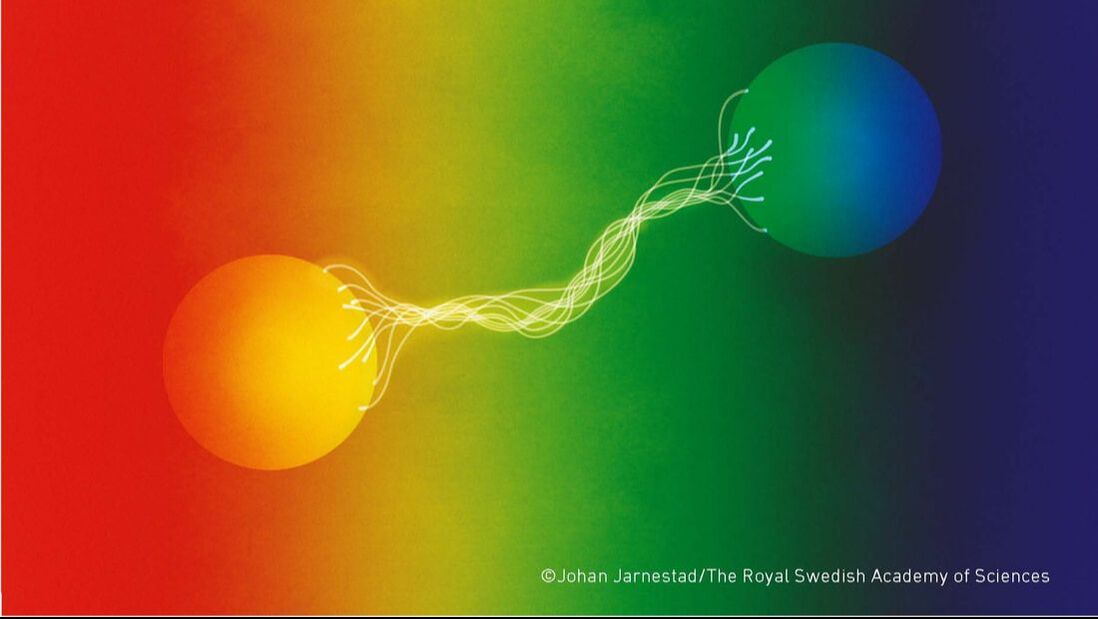

Gli esperimenti in questione iniziano negli anni ’70 col lavoro pionieristico di Clauser, raggiungono un elevato grado di accuratezza con Aspect, e vengono successivamente potenziati nella mani di Zellinger. Ma di che esperimenti si tratta, e di che cosa, più in generale, stiamo parlando? Non tutti se ne sono accorti, ma negli anni ’30 del secolo scorso c’è stata una grande rivoluzione scientifica che ha modificato completamente la nostra visione della natura. Il primo passo in realtà fu compiuto nel 1900 da Max Planck. Il fisico austriaco stava studiando quello che all’epoca veniva considerato il paradosso della radiazione del corpo nero, cercando di capire perché i dati sperimentali erano in netto disaccordo con la teoria di Raylegh, allora accettata da tutti, che si basava sul presupposto che la massa irradiasse la stessa energia su tutto lo spettro delle frequenze, e cioè che la radiazione di un corpo caldo fosse direttamente proporzionale alla sua temperatura assoluta. L’equazione di Raylegh funzionava bene, e le previsioni si accordavano perfettamente con i dati sperimentali, solo nel range di frequenze che andavano dall’infrarosso al verde, ma quando le frequenze diventavano più elevate in conti non tornavano più dato che la radiazione prevista sarebbe dovuta diventare infinita. Questo problema apparentemente insormontabile venne identificato come la “catastrofe ultravioletta”. Per risolverlo Planck fu costretto ad ipotizzare una cosa allora impensabile, e cioè che che l’energia fosse emessa in pacchetti, cioè in un’unità discrete o quanti (dal latino quantum, quantità), secondo una formula che descriveva l’energia emessa dai corpi come direttamente proporzionale alla frequenza della radiazione luminosa e ad una costante h (da allora costante di Planck) introdotta proprio perché grazie ad essa c’era il perfetto accordo con i dati sperimentali. Ci fu molta perplessità a riguardo, non solo da parte della comunità scientifica, ma anche da parte dello stesso Planck, che considerava quello quantistico un escamotage matematico squisitamente teorico. Fu solo nel 1905, grazie al genio di Albert Einstein, che il concetto di quanto assunse un significato fisico. Einstein utilizzò la costante di Planck per spiegare l’effetto fotoelettrico (cioè l’emissione di elettroni da una superficie metallica quando essa è colpita da una radiazione elettromagnetica a partire da una determinata frequenza), e con la sua celebre dimostrazione la radiazione elettromagnetica venne considerata come costituita da quanti di energia, i cosiddetti fotoni: nasceva così la fisica quantistica. Da lì in poi fu un susseguirsi di teorie e di conferme sperimentali, soprattutto a partire dagli anni venti del novecento, che hanno riguardato fenomeni atomici, nucleari, ottici, le particelle elementari, lo stato solido della materia. Ma non è stato un percorso semplice e lineare: il carattere controintuitivo della nuova fisica ha fatto dubitare molti eminenti studiosi, tra cui lo stesso Einstein che aveva contribuito alla sua fondazione, che la descrizione quantomeccanica dei fenomeni fosse corretta, e che la natura a scala microscopica apparisse così bizzarra e “illogica” perché la teoria era incompleta e andasse integrata considerando proprietà della materia che ancora non erano state scoperte, le cosiddette “variabili nascoste”. Le sottili argomentazioni dei detrattori della teoria furono alla base di un fecondo dibattito, soprattutto negli anni ’30 del secolo scorso, a cui presero parte le menti più geniali del pianeta, tra cui Einstein, Bohr, Heisenberg, Schrödinger, Von Neumann, Wigner, Born, e che alla fine resero la nuova quantistica la teoria scientifica con il maggior numero di conferme sperimentali. Eppure, ancora oggi il comportamento delle particelle ci appare bizzarro: la nostra esistenza si svolge ad una scala di diversi ordini di grandezza superiore a quella di cui si occupa la microfisica e siamo abituati ad avere a che fare con oggetti che sembrano possedere proprietà stabili e descrivibili. Le nostre “cose” occupano una determinata posizione o si muovono con una velocità misurabile, e interagiscono secondo lo logica della causa ed effetto. Ma i componenti fondamentali della natura (e non solo quelli) non si comportano così. Facciamo tre esempi. Nel primo caso, se due entità prodotte dallo stesso evento vengono poste ad una distanza tale che tra loro è impossibile comunicare, neanche alla velocità della luce, possono mostrare sbalorditive correlazioni nel loro comportamento, tanto che una misurazione su una di esse sembra avere un’influenza istantanea sulla misurazione eseguita sull’altra, come se le due entità nate insieme e successivamente separate, fosso rimaste inspiegabilmente e indissolubilmente legate, intrecciate insieme in un unico destino (fenomeno dell’entanglement). Nel secondo caso prendiamo un fotone, il pacchetto di energia considerato come l’unità fondamentale della luce: esso può avere un duplice comportamento, e agire sia come se fosse una vera e propria particella e sia come un’onda, producendo in quest’ultimo caso i fenomeni di interferenza tipici della radiazione elettromagnetica. Il suo stato rimarrà ambiguo e indefinito fino a quando su di esso non si effettuerà una misurazione: se si misureranno le proprietà tipiche di un’onda, per esempio l’interferenza, allora il fotone si comporterà come un’onda; se invece si misurerà una proprietà tipica delle particelle, il fotone agirà come una particella. Questo ci fa capire che non è possibile affermare se il fotone abbia una natura corpuscolare o ondulatoria: bisognerà prima scegliere il tipo di dispositivo sperimentale ed eseguire la misura. Quello che allora potremmo descrivere sarà lo stato del fotone dopo la misura, che è una cosa diversa dal dire se il fotone è di natura corpuscolare o ondulatoria. Come terzo esempio citiamo il principio di indeterminazione (o meglio, incertezza) di Heisenberg. Nella vita di tutti i giorni, se consideriamo un’auto che sfreccia sull’autostrada e disponiamo degli strumenti opportuni (per esempio un tachimetro montato sull’auto o un rilevatore laser posto al lato della carreggiata) siamo in grado di determinare la velocità (o la quantità di moto se la moltiplichiamo per la massa dell’auto) e la posizione del veicolo. Questa misurazione ci sembra banale, o quantomeno routinaria, dato che con un semplice navigatore possiamo stabilire con precisione la nostra posizione e velocità istantanea (oltre che quella media, ecc.). Ebbene, nel mondo microscopico le cose non vanno così. Il principio di Heisemberg stabilisce dei limiti invalicabili e strutturali alla misurazione di grandezze fisiche coniugate come la posizione e la quantità di moto. L’impossibilità di misurare contemporaneamente queste due grandezze non dipende dalla sofisticatezza dello strumento utilizzato, ma sembra essere proprio una caratteristica della realtà. Prima di addentrarci nella descrizione degli esperimenti premiati dal Nobel, stabiliamo alcune nozioni fondamentali che ci aiuteranno ad orientarci nella terminologia di questa nuova scienza. Chiamiamo stato quantico quello che definisce tutte le grandezze fisiche che caratterizzano un dato sistema (un elettrone, per esempio), sempre tenendo conto che il principio di Heisemberg ci impedisce di conoscere contemporaneamente due grandezze coniugate o incompatibili. Nel caso del fotone lo stato quantico è definito dalla direzione del movimento, dalla frequenza (la luce e i fotoni sono oscillazioni del campo elettromagnetico) e dalla polarizzazione lineare. Quest’ultima caratteristica esprime la direzione del campo elettrico associato al fotone, e si può misurare con particolari pellicole dette polarizzatori (utilizzate nelle lenti polaroid) che sono costruite in modo da lasciare passare tutta la luce che incide con un angolo di 90° quando l’asse di oscillazione della luce è parallelo a quello della pellicola, mentre la radiazione polarizzata perpendicolarmente con tale asse viene completamente bloccata. A questo punto dobbiamo introdurre un altro concetto cardine della quantistica che è la probabilità, perché ciò che lo stato quantico di un sistema indica è proprio la probabilità di ogni possibile risultato degli esperimenti eseguiti sul sistema. Quando la probabilità è pari ad 1, l’evento si verificherà con certezza, se è pari a 0 non si verificherà con altrettanta certezza, mentre se ci troviamo nel range di probabilità compresa tra 0 e 1, allora siamo nel regno dell’indeterminato e non possiamo prevedere esattamente cosa accadrà. Nel caso del fotone e dei polarizzatori, ruotando quest’ultimi in vari esperimenti, il singolo fotone viene trasmesso con la probabilità pari a 1 se il fotone è polarizzato secondo l’asse di trasmissione della pellicola, con probabilità pari a 0 se l’asse di polarizzazione è perpendicolare all’asse di trasmissione della pellicola; se invece il fotone ha una polarizzazione lineare che forma un angolo compreso fra 0° e 90°, la probabilità che il fotone passi attraverso la pellicola ammonta ad un numero compreso fra 0 e 1, che rappresenta il quadrato del coseno dell’angolo in questione. Se la probabilità è 0,6, significa che su 100 fotoni con angolo di polarizzazione corrispondente a quella probabilità, ne verranno trasmessi 60, ma non sappiamo dire in anticipo quali fotoni di quei cento passeranno e quali invece verranno bloccati. Un altro concetto di cui non possiamo fare a meno è quello della sovrapposizione, il principio secondo cui è possibile che si crei un nuovo stato che sia la sovrapposizione di due stati quantici originari. Per esempio, se un fotone ha due stati in cui uno ha la direzione di polarizzazione perpendicolare alla direzione di polarizzazione del secondo, il principio di sovrapposizione ci dice che da quei due stati originari se ne possono originare altri in cui la direzione di polarizzazione forma un angolo minore di 90° con le due direzioni di partenza. Bastano questi pochi cenni sulla microfisica a darci l’idea di quanto grande sia la distanza che separa la quantistica dal modo di pensare che ha caratterizzato l’indagine dell’uomo per oltre duemila anni, dai presocratici fino all’interpretazione probabilistica della funzione d’onda di Born. Questo profondo divario fisico e filosofico emerge perché la meccanica quantistica è una teoria in cui lo stato quantico (o funzione d’onda) è la descrizione completa del sistema, e quando una delle grandezze che definiscono quello stato è indefinita significa che è oggettivamente indefinita, che quello è il modo di essere di quella proprietà, e che questo suo rimanere indefinita non dipende dai limiti del ricercatore, ma è una caratteristica strutturale del mondo microscopico. Infatti, il risultato della misurazione di una grandezza indefinita non dipende dallo stato quantico, che pure identifica in modo completo il sistema, ed è assolutamente dovuto ad una “casualità oggettiva”, e anche la probabilità di ogni possibile risultato della misura è anch’essa oggettiva. Si delinea quindi una teoria che ha almeno due tipi di dualismo: il primo, empirico, che vede la presenza all’interno della stessa teoria di due entità che erano incompatibili dal punto di vista classico, e cioè le particelle e le onde (come abbiamo visto Planck e Einstein avevano introdotto quantità discrete “corpuscolari” all’interno della teoria della radiazione elettromagnetica di Maxwell, mentre in seguito De Broglie e Schrödinger introducevano le cosiddette “onde di materia” nella meccanica di Newton, che si occupava di particelle), e il secondo, formale, che vede i fenomeni quantistici perfettamente descritti nella loro evoluzione temporale da un’equazione deterministica del moto a cui si contrappone una descrizione squisitamente probabilistica dei risultati delle misurazioni. E quanto visto finora è solo un assaggio della complessità della questione. Le cose diventano ancora più strane e sbalorditive, sempre secondo il senso comune, quando lasciamo i sistemi semplici (per esempio, un singolo fotone o un singolo elettrone) per affrontare un sistema costituito da due parti correlate, per esempio due fotoni emessi da un singolo atomo di calcio eccitato che ritorna al suo stato fondamentale. Stabiliamo che i due fotoni si allontanino in direzioni opposte: come abbiamo visto in precedenza, è possibile che in uno stato quantico della coppia i fotoni hanno una polarizzazione lineare secondo l’asse verticale, mentre in un altro stato entrambi i fotoni sono polarizzati linearmente secondo la direzione orizzontale. Ora, il principio di sovrapposizione prevede che ci possa essere uno stato in cui troviamo quantità uguali dello stato a polarizzazione verticale e di quello a polarizzazione orizzontale. Questo stato di sovrapposizione possiamo chiamarlo con la lettera greca psi, Ψ0 che di solito si usa per rappresentare le funzioni d’onda. Ψ0 ha delle caratteristiche davvero sorprendenti: dato che ha quantità uguali di stati di polarizzazione, se noi poniamo lungo il cammino dei due fotoni dei filtri polarizzatori orientati orizzontalmente, la probabilità che entrambi i fotoni vengano bloccati è 0,5. La cosa rilevante è che o entrambi i fotoni vengono bloccati o entrambi vengono trasmessi. Se vogliamo possiamo ruotare entrambi i polarizzatori di uno stesso angolo, ma il risultato non cambierà: entrambi i fotoni subiscono lo stesso destino. Le loro esistenze sono aggrovigliate, intrecciate, sono entangled! Per usare una metafora, è come se il secondo fotone fosse a conoscenza di cosa fa il primo, e accordasse il proprio comportamento a quello dell’altro, cioè se uno passa, lo fa anche l’altro, se uno viene bloccato, si comporta così anche l’altro. E tutto senza che vi sia nessuna possibilità di comunicazione tra i due. È proprio questo fenomeno dell’entanglement ad aver suscitato le perplessità di Einstein, dato che il comportamento dei fotoni “gemelli” sfidava apertamente la sua teoria della relatività e il concetto di località. La relatività ristretta stabilisce che nessun evento può avere effetti che si propagano con velocità superluminali, cioè superiori a quelle della luce. La velocità della luce è un limite invalicabile, il caposaldo assoluto di una teoria che si chiama relatività. È proprio questo limite ad impedire che ci possano essere le cosiddette “azioni a distanza” di newtoniana memoria, ed è proprio l’apparente violazione di questo confine a far insorgere l’intelletto sopraffino di Albert Einstein. Il sommo genio, insieme a Podolsky e a Rosen, sviluppa nel 1935 un celebre esperimento mentale passato alla storia come Paradosso EPR (Einstein-Podolsky-Rosen) in cui si considera valido il concetto di realismo locale, secondo il quale le particelle hanno determinate caratteristiche indipendentemente dall’atto di misura (le particelle, con le loro proprietà, esistono anche se non misurate) e quindi indipendentemente dall’osservatore, e che gli eventi fisici hanno una velocità di propagazione finita e inferiore alla velocità della luce, il che significa che i sistemi possono interagire solo se vicini o con la mediazione di un campo tipo quello gravitazionale o elettromagnetico. Quindi, dato che l’entanglement sembra violare entrambe queste nozioni di base, allora la quantistica così com’è non può descrivere efficacemente la realtà. È evidente, secondo EPR, che gli stati quantici non sono descrizioni complete, e i singoli sistemi differirebbero secondo caratteristiche, le già citate variabili nascoste, non prese in considerazione dallo stato quantico. In pratica, è come se le particelle avessero un insieme di istruzioni nascoste così da permettere, durante l’accoppiamento, una sorta di sincronizzazione delle varie istruzioni in un meccanismo (sempre nascosto) che determinerebbe i risultati delle misure successive. La quantistica sarebbe quindi “strana” non perché molte delle proprietà delle particelle rimangono in uno stato indefinito che è governato da leggi probabilistiche, ma solo perché non abbiamo un quadro complessivo di tutti i parametri e di tutte le variabili. La meccanica quantistica sarebbe quindi una teoria incompleta. Questo dibattito, rappresentato in parte da EPR, si è prolungato fino al 1964, anno in cui un giovane fisico dell’Irlanda del Nord, John Stewart Bell, elaborò una disuguaglianza tra i risultati di misurazioni di variabili fisiche correlate, disuguaglianza che viene soddisfatta dalle assunzioni proprie delle teorie locali. La meccanica quantistica vìola, in generale, questa diseguaglianza. Dal lavoro di Bell emerge chiaramente che le argomentazioni del Paradosso EPR e quindi le spiegazioni teoriche locali a variabili nascoste entrano in un conflitto insanabile con la teoria quantistiche. In pratica la diseguaglianza dimostra che nessun modello che sia locale, in un senso ben determinato, riesce a concordare con tutte le previsioni statistiche della meccanica quantistica. A livello teorico, la diseguaglianza di Bell è importante perché ci consente di dirimere sperimentalmente tra teorie che seguono il realismo locale da quelle non realiste come la quantistica, che è locale nel senso fisico del termine, non locale nel senso “filosofico” universale di Einstein e che ha un formalismo che prevede le correlazioni a distanza. Ora che era stato trovato lo strumento teorico, bisognava verificarlo con esperimenti progettati ad hoc, cosa non semplicissima dato che si parla di accoppiare, poi dividere, spedire a centinaia di metri di distanza (se non chilometri), e infine misurare singoli fotoni. Già nel 1969, un giovane fisico e futuro premio Nobel di nome John Clauser, di stanza a Berkley, proporrà (insieme a Michael A. Horne, Richard A. Holt e Abner Shimony) un esperimento per verificare l’esattezza della disuguaglianza, esperimento che poi verrà realizzato nel 1972 e che rappresenta il prototipo di quelli che verranno realizzati con fotoni entangled e con polarizzatori. In pratica, due fotoni provenienti da un atomo prima eccitato e che poi ritorna al suo stato fondamentale, vengono fatti muovere in direzioni opposte e condotti, con opportune lenti, ad incidere su polarizzatori con assi di trasmissioni paralleli. I polarizzatori venivano poi ruotati in varie posizioni (sempre tra loro parallele) e infine registrate le coppie di fotoni trasmesse. L’esperimento di Clauser è stato poi ripetuto nel 1975 da Fry e Thompson, e in seguito da altri gruppi di sperimentatori, e in tutti questi casi i risultati sperimentali concordavano con le previsioni della meccanica quantistica.. L’unica speranza dei sostenitori del modello a variabili nascoste di era affermare che l’esperimento non era decisivo, in quanto i polarizzatori rimanevano in una determinata orientazione per un minuto, tempo più che sufficiente, viste le distanze tra sorgenti e polarizzatori, per scambiare informazioni e rendere non valide le condizioni di località di Bell. A questo punto entra in scena Alain Aspect, che insieme a Jean Dalibard e Gérard Roger (Università di Parigi) mette a punto un esperimento molto più sofisticato, nel quale la scelta fra le orientazioni dei polarizzatori veniva regolata da commutatori ottici che agivano mentre i fotoni stavano percorrendo le loro traiettorie. A seconda dello stato di un commutatore, i fotoni potevano venir deflessi verso altri polarizzatori. Il tempo di percorrenza della luce tra gli analizzatori era maggiore di quello impiegato per la commutazione, così da escludere ogni rischio di “contaminazione” per comunicazione. Anche in questo caso, i risultati sperimentali erano a sostegno della meccanica quantistica, ma i sostenitori del modello a variabili nascoste contestarono l’esperimento, affermando che la commutazione tra i polarizzatori era periodica e non casuale, lasciando possibili spiragli ad una comunicazione. Alla fine degli anni novanta del secolo scorso, Anton Zellinger, ora all’Università di Vienna, ha cercato di risolvere questo problema usando direzioni di misurazione della polarizzazione non periodiche e veramente casuali. Inoltre le direzioni venivano determinate un attimo prima della misura, quindi i famigerati segnali nascosti non sarebbero stati in grado di comunicare se non viaggiando più velocemente della luce. Quindi, la località era sistemata però…rimaneva un però! Gli esperimenti di Clauser, Aspect e Zellinger avevano un problema: i fotoni. Utilizzare i fotoni è complicato perché nella maggior parte dei test non si generavano fotoni o si erano persi lungo la loro traiettoria, e quindi gli sperimentatori dovevano ipotizzare che i test che portavano ad un risultato fossero rappresentativi di tutti i test, e che quindi il campionamento fosse stato equo. Ma questa assunzione del campionamento equo non era in grado di escludere che nei casi in cui il test non funzionava per perdita di fotoni, accadesse qualcosa di diverso dal previsto lungo il tragitto dei fotoni e che sommando ai test riusciti anche quelli “strani” allora la diseguaglianza di Bell non fosse violata, e le variabili nascoste potevano “riprendere fiato”. Sono dovuti passare altri anni e alla fine i ricercatori sono riusciti ad eliminare il problema del campionamento utilizzando forme di materia complessa al posto dei fotoni. Parliamo di ioni, atomi, circuiti, ecc., che si possono rendere entangled. Ma (c’è sempre un ma!) le particelle così vengono a trovarsi molto vicine tra loro e possono comunicare, riaprendo la scappatoia della località. Per mettere fine a tutte le speranze dei “nascostisti” bisognava progettare esperimenti che fossero esenti da problemi di non casualità, di località e di campionamento. E finalmente, solo nel 2015, ben quattro gruppi di ricerca hanno raggiunto lo scopo: 1) Ronald Hanson del policlinico di Delft, utilizzando l’entanglement dello spin di due elettroni, ciascuno contenuto in una lacuna di carbonio in diamanti posti a 1280 metri di distanza; 2) Krister Shalm del NIST, utilizzando fotoni entangled; 3) Anton Zellinger, utilizzando sempre fotoni; 4) Herald Weinfurthe dell’Università Ludwig-Maximilians di Monaco di Baviera, che ha utilizzato atomi di rubidio separati da 400 metri di distanza, in un esperimento simile a quello di Hanson. Tutti questi esperimenti dimostrano ancora una volta che il modello a variabili nascoste non è compatibile con la natura e che quindi ci troviamo in un mondo regolato dalle leggi della meccanica quantistica. Dobbiamo rassegnarci all’esistenza di un universo “bizzarro” in cui un’inquietante correlazione a distanza sembra possibile, e in cui la casualità e l’indeterminazione sono la normalità. Mi sembra abbastanza per poter conferire dei premi Nobel.

0 Commenti

|

AutoreRuggero Condò, autore e saggista, è laureato in Scienze geologiche e in Filosofia della scienza. ArchiviCategorie |

Feed RSS

Feed RSS